Контрольный листок, 2014, № 10 (50)

Против ЕГЭ

Итоги ЕГЭ: опыт анализа

© Люция Нуриева, Сергей Киселев

Продолжение; начало см. в № 9

Технология проверки работ

Проблемы оценки уровня знаний выпускников не ограничиваются недостатками технологии измерений. Серьезные изъяны имеют также инструментарий проверки и ее организация.

За все время проведения ЕГЭ повышенное внимание организаторов уделялось качеству контрольно-измерительных материалов. И это правильно. Однако, абстрагируясь от их содержания, заметим, что сами КИМы баллов не начисляют. Баллы начисляются по бланкам ответов, содержимое которых знаний учащихся может не отражать. Связано это со сложностью заполнения бланков, оплошностями школьников при проставлении ответов, ошибками и низкой дисциплиной верификации.

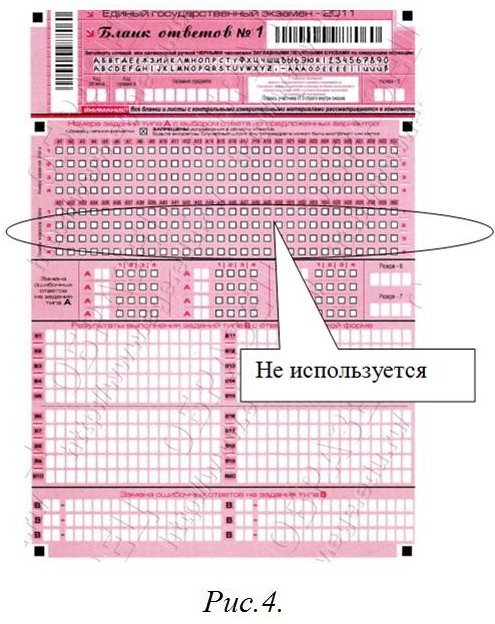

Начнем с того, что бланк ответов, единый для всех предметов, в части А рассчитан аж на 60 вопросов (рис.4). От вплотную налепленных ячеек рябит в глазах. Между тем в КИМах всех дисциплин часть А насчитывает не более 30 заданий (кроме биологии, где их 36). Таким образом, второй блок клеток бланка почти не используется. За все 10 лет существования экзамена более трети ячеек для ответов части А не использовались никогда! А второй блок клеток задействовался лишь в 5–6% случаев (такова доля человеко-экзаменов по биологии).

В 2011 году среди восьми сотен омских учащихся, чей результат по русскому языку составил свыше 80 тестовых баллов (Это лучшие ученики, составляющие лишь 6% всех участников), в среднем за часть С потеряно 2 первичных балла из 23 возможных (или 8%), за часть В — 1 из 11 (или 9%). Зато за часть А потеряно 6 первичных баллов из 30 (или 20%). В сложных заданиях части В и С у сильных школьников ошибок вдвое меньше, чем в куче простейших угадаек. Объяснение этому может быть одно: ошибки в части А у хорошо подготовленных выпускников связаны в основном с банальной путаницей в постановке крестиков в «частоколе» клеток заданий, не представляющих в действительности для этой группы экзаменуемых практически никакой трудности (апелляция, кстати, здесь не предусмотрена). В этих условиях большую роль при ранжировании участников по высоким баллам играют уже не столько собственно знания (а уровень подготовки таких учащихся понятен), сколько иные факторы: скрупулезность в заполнении клеточек (теперь мы проверяем и такие характеристики выпускников) и качество распознавания и верификации ответов.

В иностранных языках закрытые вопросы вообще имеют только три альтернативы. Здесь бланк ответов не соответствует КИМам. Любой верификатор подтвердит, что школьники вместо третьего (последнего в КИМах) проставляют четвертый (последний в бланке) вариант. Это автоматически означает ошибку. Приведем замечательный фрагмент отчета ФИПИ по английскому языку:

«…количество ошибок при переносе ответов в бланки (запись лишних слов или символов, ошибки в выборе позиции ответа, приводящие к полному отсутствию ответов в бланке ответов по какому-либо заданию) (выделено нами. — Авт.), продолжает увеличиваться, что свидетельствует о снижении общей функциональной грамотности экзаменуемых, а также о том, что при подготовке к экзамену уделяется недостаточное внимание ознакомлению учащихся с бланком ответов и правилам работы с ним».

Может ФИПИ стоит просто почистить бланк от мусора, разрядить клетки и привести его в соответствие КИМам?

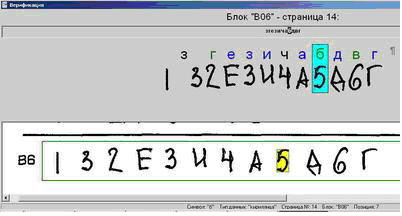

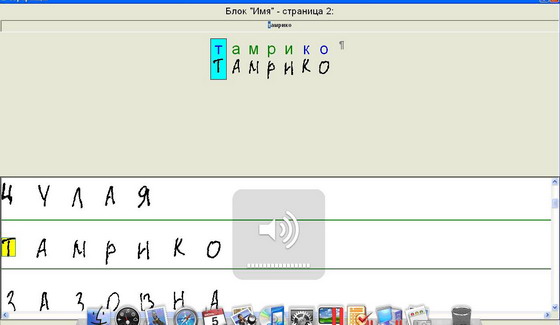

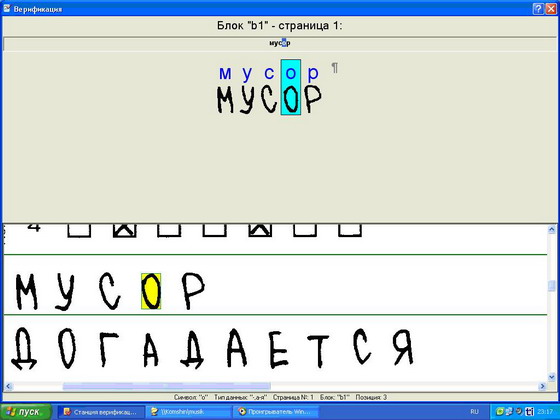

На протяжении почти всех 10 лет проведения ЕГЭ верификация ответов осложнялась конструкцией КИМов. Закрытые вопросы, где ответ состоял из набора букв, проверялись с большим трудом. При распознавании текста машиной заглавная буква «А» путается с буквой «Д» и наоборот, «И» с буквой «Ч», «Н», «К» и т.д. Если школьник пишет прописью (а значительная часть участников экзамена игнорирует требование писать заглавными печатными буквами), то машина путает буквы «б», «в», «д». Даже верификатор иной раз затрудняется сразу определить, какую букву проставил школьник. Нередки случаи, когда вместо номера альтернативы учащийся пишет ее текст.

На рисунке 5 приведен процесс верификации задания, где школьник должен записать ответ символами кириллицы. Здесь изображена чрезвычайно распространенная ошибка, когда вместе с кодом альтернативы пишется ее порядковый номер. В нашем примере для записи ответа использовались цифра 3 и буква «З». Внешне они неразличимы. Верификатор должен оставить только допустимые символы, поэтому 3 и «З» останутся. Верный ответ будет верифицирован как ошибочный. И это хорошо, если в условиях жесточайшего аврала оператор станет досконально разбираться во всех таких записях.

Между тем проблема решалась элементарно. Обозначения альтернатив следовало бы сразу сделать цифровыми. По свидетельству ФИПИ, замена в 2011 году в вопросе В5 по обществознанию буквенного обозначения вариантов ответа на цифровое дало 20% рост его решаемости. Иными словами, низкий показатель был вызван не слабыми знаниями учащихся, а ошибками верификации.

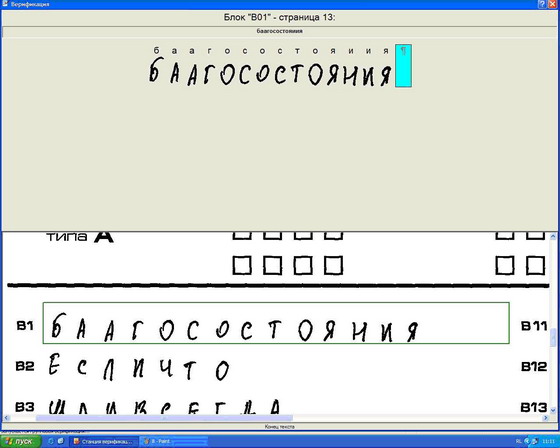

Сама программа верификации «TestReader» также нуждается в совершенствовании. Нацеленная на распознавание каждого знака, она составляет бессмысленные наборы символов из вполне читаемых слов. На рис. 6 приведен пример верификации слова «Благосостояния», где «TestReader» составил слоги, в русском языке не встречающиеся («БААГ» и «ЯИИЯ»)[8]. Между тем не следует делать упор на точности распознавания каждой буквы. Требуется правильно распознавать слоги. Процесс значительно ускорится, если программа сама будет подбирать в слоги наиболее вероятные сочетания букв, ибо практически вся верификация состоит из исправлений такой простейшей несуразицы.

Сомнительным представляется и использование единой для всех предметов системы распознавания. Действительно, программа «TestReader» позволяет работать с различным материалом (символы латиницы, кириллицы и цифры) и отличает один знак от другого. Но понять ответ целиком она не в состоянии. К тому же ответы состоят не только из слов. У каждой науки своя знаковая система: латинские и греческие буквы, математические символы, химические и физические формулы и т.д. Программы верификации должны «понимать» с каким материалом они имеют дело, в чем «TestReader», увы, абсолютно «не разбирается». Поэтому распознавать записи, представленные в виде формул, на ЕГЭ за десять лет так и не научились.

Технологию проверки работ невозможно рассматривать также вне контекста ее организационных вопросов. Острой проблемой экзамена остается дисциплина участников, прежде всего школьников. О недоработках организаторов если сообщается, то очень немного. Между тем если взглянуть на работу региональных центров обработки информации (РЦОИ), можно обнаружить интересные вещи.

Одному из авторов статьи «посчастливилось» в течение двух лет работать в Омском региональном информационно-аналитическом центре системы образования (РИАЦ), выполняющего функции РЦОИ, участвовать в двух кампаниях по верификации школьных работ (в 2010 и 2011 годах), наблюдать организацию проведения ЕГЭ изнутри. Что-то из увиденного является общими проблемами всех РЦОИ, что-то можно отнести к местной специфике.

Главной особенностью функционирования РЦОИ является сезонный характер занятости. Работа здесь имеется только в период проведения испытаний (середина мая — июль), т.е. 3 месяца в году[10]. Во время массовой обработки экзаменационных материалов (июнь) нагрузка становится запредельно высокой. Бланки ответов следует пропустить через сканер и программу распознавания и установить соответствие их содержания символам, распознанным машиной. Установление такого соответствия осуществляется вручную операторами станций верификации. Несмотря на кажущуюся простоту, верификация является довольно трудной работой. В течение трех-четырех недель без выходных, по 8–10 часов не отрываясь от экрана, операторам необходимо сверять каракули школьников с текстом, который распознала машина. Своих сотрудников для этого в РЦОИ, как правило, недостаточно, поэтому они могут привлекать дополнительных работников по договору. На оплату верификации в регионы специально направляются деньги.

Недостаток людей для верификации РЦОИ на местах, видимо, восполняют по-разному. В Омском РИАЦ, например, «под ружье» ставят всех: не только программистов, методистов, аналитиков, но и бухгалтеров, секретаря, рабочих типографии (в Омске учителя школьные работы больше не проверяют). Наиболее стойкие сотрудники в дополнение к дневным сменам работают и по ночам: т.е. где-то 14–16 часов в сутки. Отказ от привлечения людей со стороны объясняется стремлением освоить присылаемые Москвой деньги узким кругом штатных сотрудников или «своих» людей. Верификация превращается в «калым».

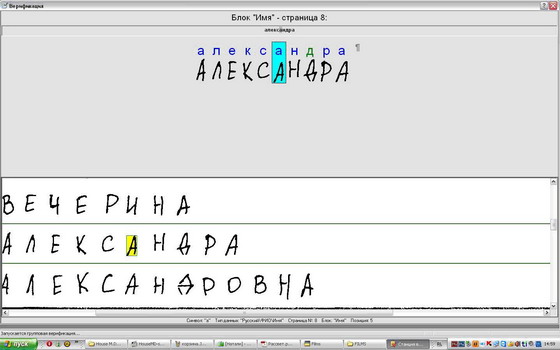

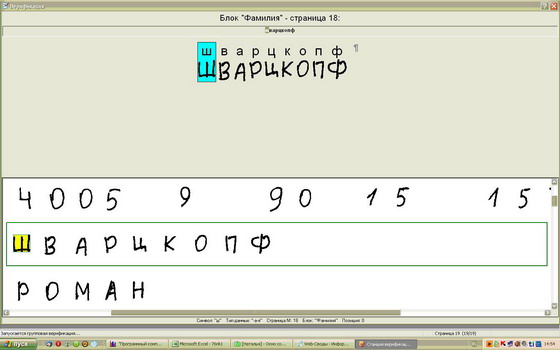

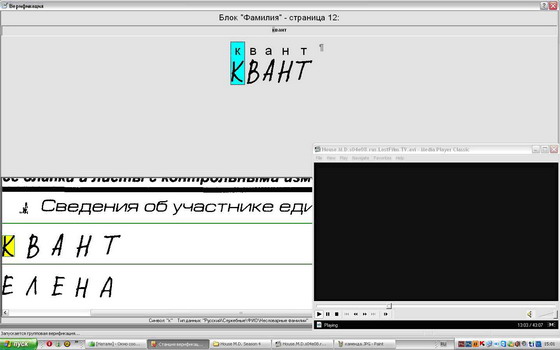

Введение Государственной итоговой аттестации (ГИА) усложнило задачу своевременной проверки работ. Вместо того чтобы привлекать людей со стороны на определенное время, Министерство образования Омской области пошло на увеличение штатов РИАЦ. В нем был создан отдел из шести человек, основной задачей которого стал сбор статистики по сфере образования (ранее этот функционал между делом выполнял всего один сотрудник). Обеспечив верификацию операторами, министерство усугубило проблему занятости. Основным времяпрепровождением новых работников в межэкзаменационный период стали пустые посиделки, блуждания в интернете, компьютерные игры и просмотр видеофильмов. К слову сказать, Омский РИАЦ собрал на своем сервере огромную видеотеку, изучению которой и стали посвящаться усилия нового отдела. Падение дисциплины отразилось и на верификации. Приведем несколько скриншотов из «коллекции», собранной работниками РИАЦ (рис.7). Одновременно работающие программы отображаются на линейке внизу, из чего следует, что вместе с верификацией специалисты центра заняты еще массой нескучных дел: читают книги, переписываются по электронной почте и смотрят кино, слушают музыку (здесь оператор настраивает громкость):и работают с программами Excel, МОРФ, Парус, собирают скриншоты. Факт того, что последние сделаны с разных станций, позволяет делать выводы о распространенности таких нарушений.

Все это, разумеется, качеству проверки работ ничуть не вредит. Не мешает даже просмотр сериалов: например, «Доктор Хаус», 4 сезон, 8 серия. Надо полагать, что предыдущие 70(!) серий этот верификатор уже посмотрел. Сколько работ он за это время «проверил» остается только догадываться. Кто-то точно подметил, что проблемы ЕГЭ - это проблемы менталитета. Хотим добавить, что менталитета не только школьников.

Бывший руководитель Рособрнадзора В. Болотов, как-то посетовав на низкую дисциплину экзамена, предложил для ее поддержания привлекать армию. Что касается Омской области, то старшину впору ставить в кабинетах, где проверяются работы учащихся.

Насколько сказываются на качестве верификации недостатки ее организации, вероятно, не скажет никто. Однако согласно статистическим исследованиям, проведенным по заказу Министерства образования и науки РФ группой специалистов Московского института открытого образования под руководством И.Ященко, в 2011 году до 7% участников экзамена получили оценку, которая не соответствует их знаниям[14]. В этот показатель вошли все погрешности измерений, в том числе ошибки верификации.

(продолжение следует)