Контрольный листок, 2013, № 11

Против ЕГЭ

Единый государственный экзамен и проблемы его анализа

© Люция Нуриева, Сергей Киселев

Но если в части «А» учащиеся могли угадывать верные ответы, то в части «В» это стало невозможным. Изменение условий записи ответа немедленно отразилось на результатах. Доля верных ответов у двоечников за решение задач части «В» сразу упала до значений от 0,1% («Решение комбинированных уравнений» до 6,3% («Простейшие показательные и логарифмические уравнения»). О распространенности выполнения ЕГЭ путем подстановки ответов наугад можно судить по результативности выполнения задач на «Нахождение производной функции» (часть «А») и «Физический смысл производной» (часть «В») (т.е. близких по теме заданий). Если в части «А» с заданием «справились» (угадали) 25% получивших двойки, то в части «В» — 1,5%. Отчеты ФИПИ также фиксируют снижение результатов решения задач базового уровня сложности при переходе от части «А» к части «В», не объясняя причин. А причина проста: значительная часть школьников «участвует» на экзамене путем гадания ответов. При этом, как показал анализ, такой способ работы в экзамене более распространен среди сельских учащихся.

Нам могут возразить, что доля гадающих сильно завышена. Однако сравните успешность решения задач базового уровня сложности в части «А» и «В», например, по графикам ФИПИ и вы придете к тем же выводам. Но дело даже не в этом. А в том, что ЕГЭ в принципе не может сказать, каким способом участники экзамена (кроме части «С») достигают того или иного результата, путем ли решения, гадания, подсказки, добросовестного заблуждения, логической или технической ошибки.

Факт формального отношения школьников к ЕГЭ по математике ФИПИ скрывает за такой фразой: «…в условиях экспериментального проведения ЕГЭ участнику экзамена известно заранее, что при любом выполнении работы ему обеспечена хотя бы минимальная положительная аттестационная отметка «3» по курсу алгебры и начал анализа. Очевидно, что это обстоятельство оказывает существенное влияние на отношение и, соответственно, на уровень подготовки к ЕГЭ более слабых выпускников, не предполагающих поступать в вузы, где требуется сдавать математику». Из приведенного заключения ФИПИ совершенно не ясны ни масштабы проблемы, ни инструментальные недостатки ЕГЭ. Между тем наличие на графике выброса в 27 тестовых баллов вызвано не спецификой подготовки выпускников, а формой записи результата в задачах части «А», т.е. пороками самой системы оценивания. Простые подсчеты показывают, что Единый государственный экзамен, столь «совершенный и современный» инструмент оценки качества образования, позволяет 2% участников получить удовлетворительную оценку по математике, даже не заглядывая в тексты задач. Для этого достаточно отгадать ответы 6 заданий.

В условиях невозможности определенно судить о реальных затруднениях школьников ФИПИ большое место отводит обоснованию качества контрольно-измерительных материалов. Однако у читателя нет возможности дискутировать на эту тему, поскольку действительное содержание КИМов закрыто от свободного доступа под предлогом антикоррупционной борьбы. Ссылки на возможность работать с открытым сегментом на сайте ФИПИ, где якобы находятся подлинные задачи, не должны вводить в заблуждение. На сайте вам предложат лишь потренироваться в решении нескольких вариантов или типов задач. Тем не менее, возможностей сравнить реальные варианты у вас не будет. Обсуждение проблемы при этом ФИПИ уводит в сторону оценки надежности и валидности конкретных заданий, как будто качество КИМов ограничивается только этим. Между тем совершенство экзаменационных материалов это не столько качество каждой задачи в отдельно взятом варианте работы, сколько всего комплекса заданий как единого целого, равноценность вариантов, неповторяемость заданий, альтернативы ответов и т.д. В обеспечении этих требований к КИМам нам предлагают всецело полагаться на добросовестность их создателей. И напрасно. Итоги ЕГЭ 2007 года тому свидетельство.

Спецификой 2007 года являются значительные изменения условий проведения экзамена, которые не могли не сказаться на результатах выпускников, но о которых ФИПИ умалчивает. Например, в Омской области вместо 90 вариантов работы, как это делалось в 2005—06 годах, в 2007 году школьникам было предложено лишь 15. В каждом из них существовало в среднем 3—4 задания, которые встречаются у соседей по аудитории. Опрос студентов математического факультета Омского государственного педагогического университета, сдававших ЕГЭ в 2007 году, показал, что на ЕГЭ по математике при ослаблении дисциплины был возможен обмен результатами задач, не только в части «А» и «В», но иногда даже в части «С»! Чистота проведения испытаний в такой ситуации определялась уже не столько качеством экзаменационных материалов, сколько порядком на пунктах проведения ЕГЭ.

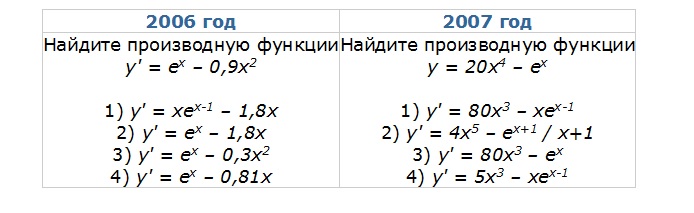

Другим важным фактором повышения результата в 2007 году стало изменение КИМов, хотя ФИПИ уверяет, что КИМы не менялись. Изменения КИМов коснулись частично характера задач (2 задачи на «Функции» были заменены на «Уравнения и неравенства»), но главным образом на форму представления заданий в части «А». В заданиях КИМов 2007 года альтернативы ответов зачастую уже содержали подсказку. От школьника не требовалось знания математики, нужно было лишь немного внимания. Так, например, если в 2006 году доля омских выпускников, получивших «два» и решивших задание на производную составила 43% (сравнительно высокий для двоечников процент объясняется повторяемостью данного задания и возможностью получить подсказку), то в 2007 году — уже 60%. Это вовсе не означает, что слабые учащиеся стали лучше разбираться в материале по производной. Предлагаемые в задачах альтернативы решений позволяли найти верный ответ методом исключения, не решая задач. У учителей появился даже специальный термин для решения подобных заданий: «метод пристального всматривания». Приведем пример:

Если в 2006 году ответ не очевиден и задачу необходимо решать, то в 2007 году верный ответ виден с первого взгляда. Конечно, хорошо, что учащиеся могут проявить такие свои качества как внимание, но для этого следует использовать тесты интеллекта. На экзамене по математике нужно проверять конкретные знания и умения. Кстати, спецификация работы 2007 года требует умения находить производную функции, а не угадывать её. Ещё пример:

В задаче 2006 года требуется сначала применить свойство логарифмов, а уж потом вычислять их. В 2007 году достаточно только знать определение логарифма. В 2006 году задание решили 26% слабых школьников (результат в области гадания), в 2007 – 43%.

Не следует думать, что авторы нарочно подобрали неудачные примеры разработчиков КИМов. Одним из главных декларируемых качеств контрольно-измерительных материалов является однотипность заданий и их одинаковая сложность. Взглянув на любой вариант работы, мы получаем достоверное представление обо всех остальных. В силу того, что омским учащимся было предложено всего лишь 15 вариантов работы, можно сделать вывод, что КИМы в 2007 году все были такими.

В своих отчетах ФИПИ совершенно умалчивает содержание предлагаемых школьникам альтернатив и ведет только обсуждение задач. Между тем, манипулируя содержанием альтернатив ответов и повторяемостью задач, ФИПИ меняет в нужную ему сторону результат экзамена. Но зачем?

Напомним, что в январе 2007 года Государственной Думой был принят Закон «О внесении изменении в Закон Российской Федерации «Об образовании» и Федеральный закон «О высшем и послевузовском профессиональном образовании» в части проведения единого государственного экзамена». Введение обязательности ЕГЭ неизбежно должно было снизить результаты, поскольку слабые школьники, которые ранее могли уклониться от сдачи экзамена, вынуждены были теперь сдавать его. Видимо для того, чтобы не портить слишком резко картину успеваемости и не вызывать критику экзамена его организаторы снизили порог требований таким способом. Однако уровень участия выпускников в 2007 году был не столь высоким, как ожидалось (в 2006 году — 47,7% и в 2007 — 52,9%). Из-за того, что регионы не торопились вводить математику в качестве обязательного испытания слабые учащиеся, как и ранее, нашли возможность уклониться от его сдачи. Результаты по стране, поэтому, оказались выше ожидаемого.

Еще одним обстоятельством, которое видимо подтолкнуло ФИПИ к манипулированию КИМами, являются итоги пробного экзамена в 2007 году. В Омской области, например, по математике был показан наихудший результат (8,69 первичных балла) за все время наблюдений (имеются в виду пробные и штатные экзамены с 2004 по 2007 год). Внесение корректив в условия проведения штатных испытаний «благотворно» отразилось на показателях успеваемости. Спустя всего два месяца, на штатном экзамене, достигнут наилучший результат по годам наблюдений (10,28 первичных балла). К такому росту первичного балла устроители ЕГЭ оказались явно не готовы. Поэтому без объяснения причин (ФИПИ о них ничего не сообщает) Министерство образования и науки РФ повышает норму для выставления отметки «3», т.е. именно за часть «А» и «В», где встречались повторяющиеся задачи и альтернативы ответов содержали подсказки. Шкалирование результатов 2006 и 2007 годов на основе «единого банка откалиброванных тестовых заданий» (если такое шкалирование вообще проводилось) в данном случае выполняет функцию «дымовой завесы», которая под видом математической процедуры маскирует низкое качество экзаменационных материалов и слабую дисциплину в 2007 году. Более того, именно эти, наиболее «грязные» с точки зрения чистоты проведения испытаний, результаты выставлены на сайте ФИПИ как иллюстрация состояния математической подготовки школьников. При этом ФИПИ делает вывод: «С учетом повышения нормы выставления отметки «3» можно констатировать, что наблюдается некоторая тенденция повышения уровня подготовки у части учащихся, входящих в группу слабо подготовленных выпускников». Комментарии излишни.

Еще одним пробелом работы ФИПИ является отсутствие попыток взглянуть на экзамен как социальную проблему. Если заполнение бланков наугад характеризует участие в ЕГЭ значительной части школьников, то результаты 2007 года иллюстрируют отношение к ЕГЭ со стороны учителей. В печати часто можно встретить сомнения в достоверности итогов ЕГЭ по территориям, когда лучшие показатели, например, по русскому языку демонстрируют школьники национальных республик. В связи с этим делаются выводы об особенностях менталитета и клановости населения ряда территорий, где нечестные должностные лица находят лазейки в системе безопасности экзамена и делают известными задания еще до проведения испытаний.

На самом деле, на наш взгляд, все дело в другом. Идея ЕГЭ как контроля качества педагогического труда не принята большинством учителей, в том числе и в Омской области. Фактически ЕГЭ воспринят как недоверие к учителю, его работе, справедливости и непредвзятости оценивания учебных достижений школьников. Какова в этих условиях должна быть позиция учителя, контролирующего ход проведения экзамена? – Помочь или не мешать учащимся пользоваться какой-либо помощью. Самое доступное в этом – закрыть глаза на нарушения дисциплины: подсказки, шпаргалки, сотовые телефоны и другие средства борьбы за оценку. Стоило лишь ФИПИ в 2007 году подготовить КИМы с одинаковыми заданиями, как низкая дисциплина экзамена тут же дала о себе знать ростом решения повторяющихся задач с фиксированным и кратким ответом. Ранее это явление из-за большего числа вариантов наблюдалось в существенно меньших масштабах. Однако и в 2005 году успешность «решения» слабыми учащимися задач А2 и А3 также частично объясняется повторяемостью этих заданий и возможностью обмена ответами. Важным фактором является и то обстоятельство, что все контролирующие проведение ЕГЭ инстанции и должностные лица на местах более заинтересованы в повышении результата, чем в обеспечении его объективности: это и учителя, и директора школ, и заведующие РОНО, и руководители областного (краевого) уровня.

Объективный содержательный анализ экзамена, таким образом, сталкивается с серьезными трудностями, заложенными в самой идеологии ЕГЭ (формализм результатов, ограниченность структуры данных и их несопоставимость по годам и территориям, бессмысленность анализа содержания работ на уровне всей страны), а также связанными с отношением к экзамену различных социальных групп – участников (формальное участие школьников, заинтересованность контролирующих органов в завышении оценок, низкая дисциплина проведения испытаний). На все это накладывается стремление специалистов ФИПИ минимизировать критику экзамена, что оборачивается манипуляцией КИМами, замалчиванием проблем, тенденциозностью подбора фактов и выводов по итогам ЕГЭ.

Изучение результатов ЕГЭ на региональном уровне еще более затруднено. Максимум на что могут рассчитывать региональные исследователи – это работа с протоколами экзамена, которые формируются ФЦТ. Однако в протоколах фиксируется только факт правильности ответов, без указания их содержания. Нет и информации о характере предложенных школьникам заданий. Региональная статистика экзамена сильно запутана. Авторы КИМов приложили большие усилия для обеспечения «чистоты эксперимента», заложив несоответствие расположения заданий в различных вариантах экзаменационных работ. Контрольно-измерительные материалы составляются на основе нескольких планов, являющихся модификациями общего плана, обозначенного в спецификации. За одинаковыми кодами заданий, на самом деле в вариантах скрываются задачи разных типов, не только не всегда соответствующие, но даже не указанные в спецификации (например, в 2005 году кроме задач обозначенных в спецификации в части «А» применялся такой тип как «Решение показательных неравенств»). Содержательный анализ работ учащихся в этих условиях возможен лишь при обеспечении доступа региональных исследователей к фактическим экзаменационным заданиям и действительным ответам школьников. Однако такого доступа у них нет.

Наглядным примером может служить ситуация в Омской области. Выпускаемые Министерством образования Омской области и выполняющим функции РЦОИ Региональным информационно-аналитическим центром системы образования Омской области (РИАЦ) сборники статистики по итогам ЕГЭ 2005—07 годов содержат лишь таблицы со средними тестовыми баллами муниципальных образований и образовательных учреждений, предоставляя читателям сопоставлять цифры и делать выводы самостоятельно. Среднеобластные результаты решения различных типов заданий в них приводятся по спецификации 2004(!) года. В течение трех лет омские организаторы ЕГЭ не только сами не знали, какие задачи по математике решали школьники, но вводили в заблуждение учителей области относительно их действительного характера, отсылая к недействующей уже спецификации. В 2008 году омский РИАЦ вообще отказался от публикации результатов решения по типам задач. Самостоятельные попытки анализа итогов ЕГЭ, выполненные РИАЦ, носят единичный и неудачный характер. Так, например, в сборнике за 2005 год РИАЦ перечисляет варианты, с которыми школьники справились лучше и хуже всего и на основании этого делает выводы об их неравнозначности. При этом даже высчитывается разница между средними величинами процентов верно выполненных «простого» и «сложного» вариантов. Однако составители сборника не обратили внимания на контингент учащихся эти варианты решавших. Так называемые «простые» варианты были распространены среди более подготовленных городских школьников, а «сложные» — среди сравнительно слабых сельских.

В то же время именно на региональном уровне и уровне муниципалитетов содержательный разбор итогов был бы наиболее продуктивен. Результаты экзамена было бы неплохо сопоставлять с показателями ведомственной статистики (образовательный, квалификационный и возрастной состав учителей, распределение нагрузки, наполняемость классов, режим работы образовательных учреждений, система подвоза учащихся из отдаленных сел, характер контингента школьников и другие местные особенности).

Однако в действующей системе распределения информации, какие бы формы и направление не принял анализ региональных итогов, он с неизбежностью содержит в себе ошибки и погрешности, заложенные формой организации ЕГЭ:

1) невозможно подвести итоги работ учащихся, не зная, какие задачи они решают;

2) подведение итогов по кодам задач и сделанные в условиях отсутствия доступа к их содержанию выводы, ориентирует педагогов на типы заданий, которые школьникам иногда даже не предлагались;

3) без анализа конкретных ответов невозможно судить о характере ошибок и затруднений учащихся;

4) сравнение усредненных баллов образовательных учреждений региона базируется на допущении, что экзамен повсеместно проводится в одинаково стерильных условиях, что далеко не так;

5) в регионах отсутствует алгоритм анализа результатов ЕГЭ, а работы ФИПИ из-за различий в уровне доступности к исходной информации не могут служить на местах стандартом исследования.

Одним из аргументов введения ЕГЭ часто называют контроль качества образования и возможность образовательных учреждений, органов управления проанализировать результативность школ по подготовке учащихся. Конкретная практика проведения ЕГЭ свидетельствует об обратном. ЕГЭ, в нынешнем его виде, не оправдывает ожиданий ни как инструмент анализа уровня математической подготовки учащихся и ни тем более как инструмент повышения качества образования. Об этом говорят уже сами организаторы экзамена: «Единый государственный экзамен призван выявить уровень и качество общеобразовательной подготовки выпускников, но не может изменить состояние образования в стране».

Совершенно очевидно, что первым шагом для повышения качества подготовки школьников является доведение до учителей школ и муниципальных органов управления образованием информации об итогах экзамена в полном объеме. Каждый учитель должен знать, какие конкретно задания решали его ученики, и какие ошибки они при этом сделали. Лучшим выходом был бы постоянно открытый банк заданий, из которого варианты ЕГЭ с учетом требований равноценности и неповторяемости ежегодно формируются случайным образом. За составителями экзаменационных заданий, таким образом, был бы установлен определенный общественный контроль, судя по 2007 году весьма полезный для всех участников ЕГЭ.

Сопоставление результатов должно осуществляться заинтересованными лицами и организациями в пределах своей компетенции. На уровне класса и школы нужно сравнивать учащихся, на уровне муниципалитетов – школы, на уровне субъекта Федерации – муниципалитеты. На уровне федерального центра итоги ЕГЭ необходимо подводить в той мере, в какой это необходимо для определения содержания образования и контрольно-измерительных материалов.

Следует устранить или нивелировать инструментальные погрешности ЕГЭ – минимизировать возможность угадывания ответов путем увеличения числа заданий отрытого типа. В заданиях с выбором ответа необходимо увеличить число альтернатив.

Необходимо отказаться от крайностей ЕГЭ и фанатизма в его применении. Во-первых, информационно-аналитическая ценность результатов ЕГЭ в сравнении с масштабами затрат ничтожна. Во-вторых, не все предметы можно втиснуть в прокрустово ложе тестов (например, литература). В-третьих, ЕГЭ не оправдывает ожиданий в точности оценки достижений учащихся. Один только его результат не является обоснованным критерием подготовки абитуриентов по причине неустранимых дефектов инструмента оценивания (тесты), в силу существенных различий характера и формы предлагаемых заданий (что особенно проявляется при сравнении итогов разных лет), дисциплины на пунктах приема экзамена и уровня «натасканности» выпускников на решение заданий в виде тестов. Поэтому в вузах необходимо вводить устный экзамен по профилирующим предметам.

Очевидно, следует также организационно развести структуры, осуществляющие разработку контрольно-измерительных материалов и анализирующие итоги испытаний. В противном случае трудно рассчитывать на объективное и беспристрастное рассмотрение проблем и результатов ЕГЭ в будущем. Для региональных органов управления образованием необходимо также разработать алгоритмы анализа и сопоставления данных, получаемых на экзамене.

Подведём итоги.

Система информации о результатах ЕГЭ оказалась поставленной «с ног на голову»: те, кто обладает исходными данными (ФИПИ), проанализировать их не могут. Те, кому информация необходима в первую очередь, прежде всего учителя, ее почти лишены. Аттестационные отметки и тестовые баллы, которые в лучшем случае доводятся до учителей, ничего не сообщают о реальных проблемах школьников.

Отсутствие сведений о характере затруднений выпускников ведет к тому, что педагоги зачастую дезориентированы в направлениях подготовки. Не случайно ФИПИ из года в год сетует на повторяющиеся типичные ошибки на экзаменах, а уровень математической подготовки школьников почти не меняется.

Отсутствие сведений о характере затруднений выпускников ведет к тому, что педагоги зачастую дезориентированы в направлениях подготовки. Не случайно ФИПИ из года в год сетует на повторяющиеся типичные ошибки на экзаменах, а уровень математической подготовки школьников почти не меняется.

Закрытость информации и отсутствие общественного контроля за содержанием экзаменационных работ создает возможность манипуляции результатами ЕГЭ, что уже не имеет никакого отношения к главной его цели – объективной оценке уровня математической подготовки школьников. Режим излишней секретности более обслуживает корпоративные интересы организаторов ЕГЭ и покрывает огрехи их работы, чем служит повышению качества обучения математике.

Как инструмент оценки знаний ЕГЭ обладает изъянами, которые существенным образом сказываются на его результатах.

Объективность и точность результатов ЕГЭ весьма относительны, порочность натаскивания школьников на решение тестов - общепризнанна.