Контрольный листок, 2014, № 11

Против ЕГЭ

Итоги ЕГЭ: опыт анализа

© Люция Нуриева, Сергей Киселев

Страница 2; вернуться на страницу 1

Ошибки содержательного анализа результатов испытаний

1. Аналитики не обращают внимания на тот факт, что под одинаковыми кодами содержатся задания разных типов. Широко распространенной ошибкой в течение первых пяти лет проведения экзамена было представление о том, что КИМы имеют одинаковую структуру. На самом деле первоначально КИМы создавались на основе нескольких планов, являвшихся модификацией общего плана, обозначенного спецификацией. Под одним кодом в разных вариантах скрывались задания разных типов. То, что такое возможно, организаторы не афишировали. Но после того как на местах стали сводить несводимое в спецификациях с 2007 года стали появляться предупреждения: «Порядок следования заданий в КИМ может быть изменен в разных вариантах». По мере накопления банка заданий составители стали отказываться от практики перестановки заданий внутри работы. По крайней мере, к 2010 году предупреждающее извещение осталось только в спецификациях по обществознанию, химии и информатике. К 2012 году оно сохранилось только в обществознании. Трудно сказать, насколько эта мера оказалась действенной в предотвращении списывания или обмена результатами во время испытаний. Однако она изначально ставила жирный крест на попытках содержательного анализа ЕГЭ на местах. Без приведения вариантов к единому порядку следования заданий статистика по типам задач представляла собой настоящую «кашу». Именно эту «кашу» и выкладывали РЦОИ в свои статистические сборники (так, в частности, было в Омске). Приводя статистику выполнения заданий, аналитики порой диву даются разбросу их решаемости, в то время как необходимо было посмотреть на тексты самих заданий.

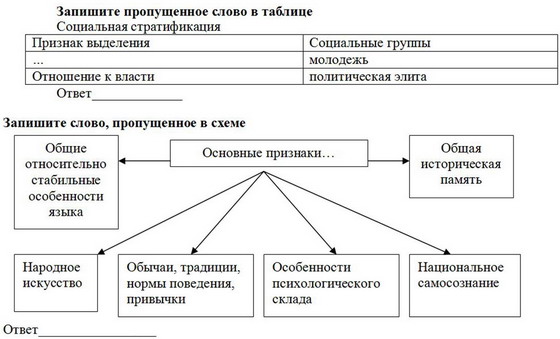

2. Аналитики не учитывают, что содержание или конструкция заданий иногда не соответствует спецификации. Хорошим примером этой ошибки является задание В1 по обществознанию, проверяемый элемент содержания которого обозначен следующим образом: «Различное содержание в разных вариантах: выявление структурных элементов с помощью схем и таблиц». Здесь, согласно спецификации, процент выполнения демонстрирует уровень умений выявлять структурные элементы с помощью таблиц и схем, но не знаний в какой-либо области курса, т.к. эти задания построены на материале из различных его разделов. Задания выглядят следующим образом:

Совершенно очевидно, что если знать решение, то записать его не составляет труда. Вот что действительно определяет успешность этой работы так это форма записи ответа. Отсутствие готовых альтернатив и элементов подсказки, присущих закрытым вопросам, ведет к снижению результата. Именно открытый характер вопроса (несмотря на то, что он относится к базовому уровню сложности) приводит к самым низким показателям. Так в 2010 году в целом по стране с этим заданием справились только 51,2% участников. Лишь с частью С и заданиями В5 и В6, представляющими собой вопросы с выбором множественных альтернатив, школьники справляются хуже. А поскольку успешность выполнения задания В1 определяется его формой было бы ошибкой не только выдавать результат за оценку умения работать с информацией, представленной в различных знаковых системах (схема, таблица), но даже высчитывать среднее значение, ибо построено оно на материале из разных разделов курса. В сопоставлении решаемостью иных заданий средний балл и процент выполнения задания В1 вообще лишены какого-либо содержательного смысла. (Если задание В1 действительно дифференцирует учащихся по умению выявлять структурные элементы с помощью схем и таблиц (ведь это вопрос открытого типа), то что же тогда измеряют все задания части А, напичканные подсказками?) Поэтому ошибочными являются выводы, например, отчета по Московской области:

«Как показывает анализ результатов ЕГЭ по обществознанию - выпускники слабо владеют умениями … анализировать и классифицировать социальную информацию представленную в различных знаковых системах, в том числе статистическую или графическую (напр. тексте, схеме, таблице, диаграмме) … Это особенно наглядно проявилось при выполнении заданий … В1».

То, что КИМы иногда могут не соответствовать спецификации, косвенно признают и специалисты ФИПИ:

«Задания, предполагающие умения классифицировать понятия, явления, социальные объекты путем установления соответствия терминов и их определений, понятий и их признаков, выпускники выполнили в этом году менее успешно, чем в предыдущие годы (25–50%). Возможно, это связано, прежде всего, с тем, что задания этого типа были построены на новом содержании (выделено нами. - Авт.), которое оказалось сложным для усвоения (организационно-правовые формы предпринимательства)».

Иными словами, классифицировать школьники стали хуже не из-за снижения умений классифицировать, а из-за смены материала классификации. Хотя по спецификации оценивались именно умения.

3. Игнорирование формы вопроса. Как-то неловко говорить банальности о том, что результативность выполнения задания в значительной мере зависит от формы записи ответа. Между тем зачастую без комментариев, беззубо и беспомощно аналитические отчеты, в том числе ФИПИ, фиксируют факты успешного решения задания повышенного уровня в сравнении с базовым. Так, например, ФИПИ в отчете по обществознанию сообщает:

«В отдельных случаях результат выполнения заданий базового уровня с кратким ответом ниже, чем результат выполнения заданий повышенного уровня с выбором ответа (выделено нами. - Авт.). Так, задание В2 второй части работы по теме "Системное строение общества: элементы и подсистемы” (средний процент выполнения 35%) выполнялось правильно почти в два раза реже, чем задание повышенного уровня А3 (средний процент выполнения 58%)».

При этом работники ФИПИ не объясняют полученный результат. А ведь причина очень проста. Открытые вопросы всегда представляют наибольшую трудность - они не содержат подсказки.

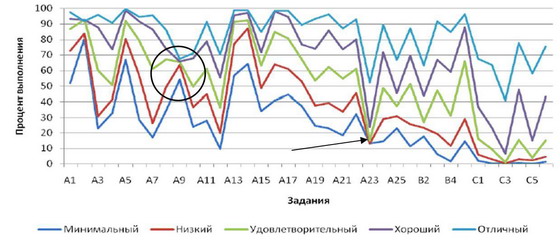

Примеры влияния формы записи ответов на результат можно найти повсюду. В региональных отчетах и справках ФИПИ часто приводятся графики выполнения задач участниками с разной подготовкой. Решаемость заданий части А среди слабых школьников никогда не опускается ниже 10–15%. Теоретически этот показатель должен находиться в районе 25%. На практике альтернативы-провокации снижают его ниже вероятностной отметки. В качестве иллюстрации приведем график ФИПИ по физике (рис. 10), который показывает, что в сравнении с другими заданиями задачу А23 менее всех провалили именно двоечники (задание отмечено стрелкой). Почему? Просто хуже выполнить его уже нельзя: форма записи ответа не позволяет это сделать.

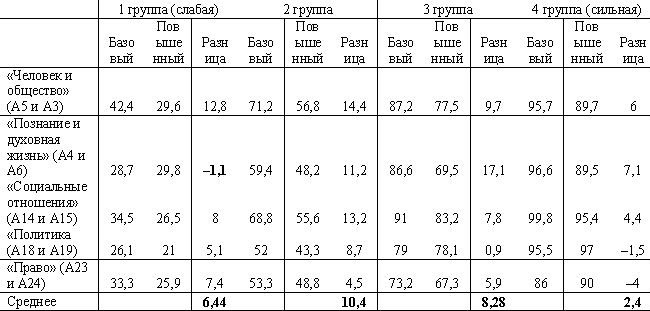

Приведём еще пример. Если сравнивать разницу решаемости заданий базового и повышенного уровня по разделам «Человек и общество» (А5 и А3), «Познание и духовная жизнь» (А4 и А6), «Социальные отношения» (А14 и А15), «Политика» (А18 и А19), «Право» (А23 и А24) в курсе обществознания, то выяснится что минимальные ее значения наблюдаются среди представителей самой слабой и самой сильной группы участников (см. табл. 3). И если в сильной группе это является свидетельством способности справиться с заданиями разной сложности, то в слабой - равной вероятности угадать верный ответ любого вопроса с 4 альтернативами. Только этим можно объяснить тот забавный факт, что по разделу «Познание и духовная жизнь» двоечники «выполнили» задание повышенного уровня сложности (А6) лучше, чем базового (А4).

Таблица 3. Решаемость заданий базового и повышенного уровня по обществознанию (2010 год)

ФИПИ, конечно, понимает, что закрытые ответы угадываются, но признает это уклончиво:

«…требование стандарта можно считать достигнутым…, если 65% и более учащихся… успешно выполнили задание с выбором ответа, проверявшее достижение данного требования. Для заданий с кратким или развернутым ответом установлена граница 50%».

Откуда такая разница? Ответ очевиден.

4. Формальный подход к анализу, игнорирование содержания заданий и альтернатив ответов. Главным недостатком аналитических работ является формальный подход к изучению результатов ЕГЭ.

В них присутствует какая-то странная уверенность в том, что КИМы подобно деталям из-под штампа хороши и одинаковы, а коды спецификации отражают все их особенности. Между тем это не так.

В КИМах встречаются задания, не имеющие решений. Например, в 2010 году в задании А5 по обществознанию составители не видят разницы между абсолютным числом и процентом (материал за 5 класс). В задании приводится динамика охвата молодежи России программами профессионального образования в процентах, а предложенные альтернативы ответа оперируют понятием «число». Для того чтобы найти верный ответ, школьникам следует не читать предлагаемый график, а засесть за вычисления. При этом знать, как менялась численность населения страны в возрасте от 15 до 34 лет, чего в условии нет.

Встречаются задания, имеющие несколько верных ответов. Так в задании А3 по химии, где специалисты из Томска зафиксировали низкий процент решаемости, в качестве альтернатив было предложено два верных ответа:

«…вопрос о водородной связи: Водородная связь не характерна для

1) H2O 2) CH4 3) HCl 4) CH3OH.

Причиной неудовлетворительных ответов является наличие двух правильных ответов 2) и 3), так как и между молекулами метана и хлороводорода не возникают водородные связи».

Встречаются невразумительные задания. Пример приводится в отчете томских коллег. Составители его, фиксируя падение решаемости одного из заданий части С по обществознанию, пишут, что школьникам требовалось

«привести три аргумента в подтверждение авторского вывода о том, что "демократия является постоянным усилием по созиданию сферы гражданского состояния и обеспечению того, чтобы частные убеждения и групповая принадлежность могли сойтись и соединиться в ней в атмосфере взаимного уважения”. Отвечающие, как правило, просто не поняли смысла задания, что и определило уровень ответов».

Немудрено. Кто же разберет такую галиматью? Интересно, насколько единодушно было бы решение этого задания у самих экспертов? Дифференцирующая способность задания - нулевая.

Встречаются задания с обратной дифференцирующей способностью. Показательной являлась ситуация с задачей А9 по физике на ЕГЭ–2010, обозначенной спецификацией как задание по молекулярно-кинетической теории. По результатам испытаний оказалось, что его одинаково хорошо (плохо) решали как слабые учащиеся, так и отличники, что было вызвано неверным подбором альтернатив. В своем отчете ФИПИ приводит диаграмму решаемости задач учащимися с различным уровнем подготовки (рис. 10), но аномальные результаты задания А9 (обведены кружком) обходит молчанием. Между тем школьники с минимальным уровнем подготовки в 20% поступивших в Омск вариантов решили это задание лучше отличников. Таким образом, дифференцирующая способность его - отрицательная. Причина провала - применение альтернатив-провокаций. Составители настолько намудрили с альтернативами ответа, что запутали сильных учащихся. Слабые выпускники, полагаясь лишь на собственный бытовой опыт (речь шла о закипании воды в кастрюле), отмечали самый простой ответ, который и оказался верным.

Рис. 10. График из отчета ФИПИ по физике в 2010 году.

О некорректности КИМов сообщают специалисты Санкт-Петербурга, анализировавшие результаты по немецкому языку, историки Томска, обществоведы Новосибирска и др.

Все это лишний раз подтверждает, что успех решаемости заданий в значительной мере определяется не столько сложностью изучаемого материала, сколько формулировкой вопроса, формой ответа и подбором альтернатив, т.е. качеством инструмента проверки. Результат уже заложен в КИМах альтернативами-провокациями и альтернативами-подсказками. Поэтому обязательным этапом изучения результатов испытаний на местах должен стать анализ используемых в данном регионе контрольно-измерительных материалов.

Не нужно также забывать, что содержание КИМов не всегда соответствует содержанию учебников. В этом признаются сами составители, в частности, по обществознанию. Оказывается «…не все содержательные линии, представленные в ЕГЭ, раскрыты в учебниках с необходимой степенью полноты…». Так ФИПИ осторожно сообщает, что берется проверять материал, которого в учебниках нет.

Томские аналитики приводят пример применения задачи С4 по физике,

«связанной с малыми колебаниями одного заряженного тела в поле другого. В критериях предложено решение, в котором используется малая величина второго порядка малости, которой пренебрегают, так как она не вносит существенной поправки в искомую величину. Такие задачи объясняются только в вузе, а в школьной программе ни по математике, ни по физике подобное не проходят. Естественно, что это задание даже никто и не приступал решать».

Показательным примером, характеризующим соответствие КИМов школьной программе, может послужить история, произошедшая в 2007 году на пробном экзамене по математике. Оценку в 100 баллов в Омске не получил никто, в том числе абсолютный чемпион Международной математической олимпиады школьников в Ханое, выпускник омского лицея № 66 Константин Матвеев. На штатном экзамене максимальный балл получили два омича. Один из них - чемпион мира. Какие измерения ведет ФИПИ?..

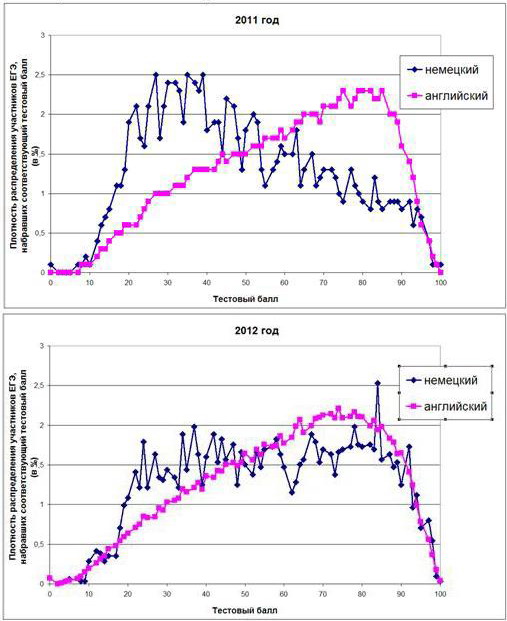

Поверхностный анализ ведет не только к ошибочным выводам, но и не позволяет своевременно корректировать инструмент оценки. Так, например, на протяжении нескольких лет специалисты ФИПИ игнорировали существенные расхождения в результатах испытаний по иностранным языкам. Разница среднего балла по английскому и немецкому языкам в 2008г. составила 8,5, в 2009 г. - 15,1, в 2010 г. - 14, 2011 г. - 10,9. В 2012 году она вдруг резко сократилась до 3,2 баллов. Как получилось, что в 2012 году средний тестовый балл по немецкому языку взлетел на 8 пунктов, а по английскому вырос только на 0,3?

Ответ мы найдем в КИМах. Если посмотреть, где более всего отстают «немцы» от «англичан», то окажется, что это задание В2 базового уровня, перегруженное призовыми баллами (за его выполнение предусмотрено 7 баллов). Именно из-за высоких баллов за выполнение задания В2 и сравнительной легкости его в КИМах по английскому и французскому языкам распределение результатов всегда было смещено вправо (типичный график - 2011 год), чего нет в немецком языке, где задание В2 сложнее (см. рис. 11), так как здесь по свидетельству специалистов из Санкт-Петербурга «тематика экзаменационных текстов и заданий зачастую не соответствует социально-личностному опыту выпускников средней школы».

Рис. 11. Распределение учащихся по тестовому баллу в 2011 и 2012 годах (немецкий и английский языки)

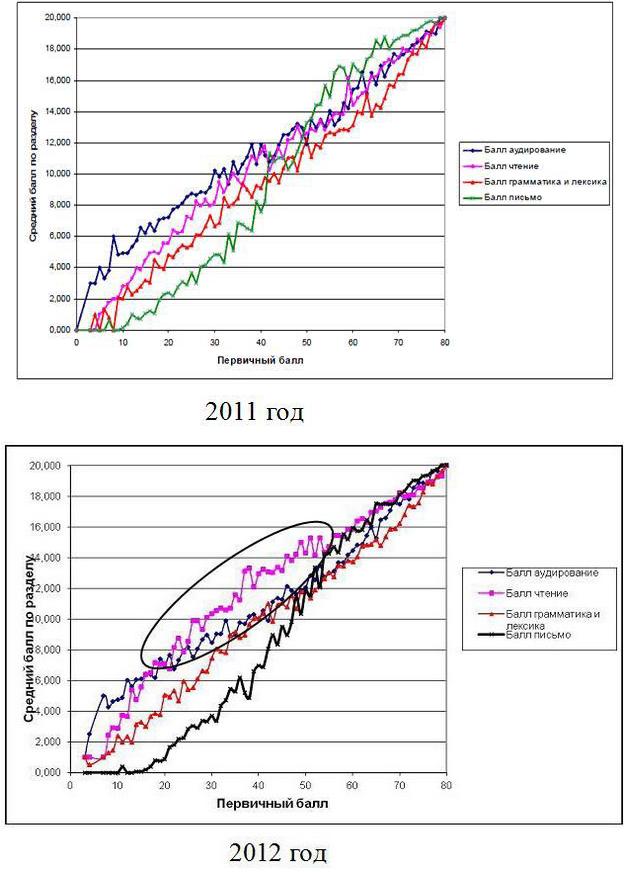

Стоило лишь поправить задание В2 и произошло чудо, которое, судя по реакции ФИПИ, требовало неприятных объяснений. Видимо поэтому ФИПИ предпочел не заметить его. В своем отчете он вскользь объяснил некоторые успехи «немцев» 10% ростом выполнения задания С2, относящегося к разделу «Письмо». Между тем, из графиков ФИПИ (рис.12) следует, что основной вклад в повышение результата внес раздел «Чтение», к которому и относится задание В2. Именно здесь учащиеся со средней подготовкой (с первичным баллом от 20 до 60) чаще всего набирали баллы.

Рис. 12. Графики ФИПИ «Зависимость общего первичного балла от результата выполнения разных разделов экзамена (немецкий язык)»

Странно, что проверяя умение школьников читать информацию, представленную в различных знаковых схемах (график, таблица), ФИПИ не может прочесть графики в собственных отчетах. Неравноценные задания по иностранным языкам не применялись бы так долго, проведи ФИПИ своевременный анализ указанных расхождений. Свои ошибки институт исправил лишь после того, как о них уже заговорили с мест, в частности питерские эксперты.

(окончание следует)