Контрольный листок, 2014, № 11

Против ЕГЭ

Итоги ЕГЭ: опыт анализа

© Люция Нуриева, Сергей Киселев

Анализ результатов

Одним из главных недостатков организации экзамена в настоящее время является система подведения итогов, а именно отсутствие их должного анализа. Материалы, посвященные «разбору полетов» в субъектах Федерации, как правило, строятся по схеме, применяемой ФИПИ: характеристика контрольно-измерительных материалов и контингента участников, сведения о выполнении различного рода задач, выводы и рекомендации по совершенствованию преподавания предмета. Солидные по объему они почти одинаковы по содержанию. Значительную часть в них занимает пересказ нормативных документов. Из года в год они повторяют одни и те же выводы и рекомендации. Более того справки ФИПИ, например, местами дословно переписаны из отчетов прошлых лет. В строгом смысле некоторые работы трудно назвать аналитическими, т.к. носят они преимущественно описательный характер. Большая часть содержащейся в них информации может быть представлена в табличной форме. Литературные дарования составителей в ряде случаев украшают эти документы, но не спасают положения. В них практически нет объяснений причин успехов и неудач школьников. Однако даже эта работа сопровождается систематическими ошибками и упущениями. Укажем на ряд из них на примере материалов ФИПИ, а также работ Московской, Мурманской, Новосибирской, Омской и Томской областей.

Рассмотрим сначала ошибки интерпретации результатов ЕГЭ.

1. Подведение итогов без учёта особенностей состава участников и условий проведения испытаний. Довольно часто аналитики делают выводы о тенденциях в изменении уровня подготовки выпускников в отчетном году путем простого сопоставления результатов с прошлогодним уровнем. Без учета особенностей состава участников и условий проведения испытаний делать это нельзя.

К сожалению, одними из первых такой пример нам показывают специалисты ФИПИ. В 2006 году они приходят к заключению о повышении уровня математической подготовки выпускников по сравнению с предшествующим годом, проигнорировав при этом увеличение доли участников из крупных городов, где по признанию самого ФИПИ показатели всегда были выше.

Омские аналитики, определяя равнотрудность заданий, принялись вычислять разницу между средним процентом выполнения «простого» и «сложного» вариантов, делая выводы о неравнозначности КИМов. Однако, как выяснилось, так называемые «простые» варианты были распространенны среди более подготовленных городских школьников, а «сложные» - среди сравнительно слабых сельских. Равнотрудность заданий и вариантов высчитывалась и в других регионах. Однако есть подозрения, что эти сравнения проводились без учета особенностей состава участников, т.к. местные специалисты данную проблему не поднимали вовсе.

Длительное время распространенной ошибкой было невнимание к условиям проведения экзамена, напрямую определяющим его результаты. В 2004–2008 гг. происходило массовое подключение к ЕГЭ новых регионов. Обязательность экзамена вела к расширению состава участников за счет нежелающих его сдавать. Чтобы побороть сопротивление эксперименту на местах Рособрнадзор установил правило «+1», гарантирующее выпускникам получение удовлетворительной отметки при неудовлетворительном результате. Но это стимулировало не участие в испытаниях, а его имитацию. На экзамене школьники стали наобум рисовать крестики в бланке ответов и сдавать работы. И такая форма «выполнения» заданий становилась все популярнее.

Размеры саботажа обязательных экзаменов в те годы поражают. Например, в 2007–2008 годах доля школьников, выполняющих задания по математике наугад, составляла до 20% по стране. Поражает и другое - близорукость специалистов, этот саботаж не замечающих. Более того, ФИПИ в своих отчётах преднамеренно замалчивал проблему, пряча неприятные факты в обтекаемых выражениях:

«При интерпретации результатов ЕГЭ следует иметь в виду, что значительный процент учащихся, показавших неудовлетворительный или невысокий уровни подготовки, частично объясняется отсутствием положительной мотивации на овладение курсом математики у слабо подготовленных выпускников, которым известно заранее, что при любом даже неудовлетворительном выполнении работы им обеспечена хотя бы минимальная положительная аттестационная отметка "3” или они не планируют поступать в вузы, где надо сдавать математику».

«Холодным душем» для омского руководства образованием стали, например, результаты экзамена по математике в 2005 году. Область оказалась в пятерке худших регионов страны. Все чувствовали, что здесь что-то не так, но объяснить произошедшее не могли. Омский аналитический центр только сводил статистику и разводил руками. Между тем основной причиной низких результатов была бездумная политика руководителей разного уровня. С их подачи среди школьников широко развернулась агитация «за ЕГЭ»: «Дети! Не волнуйтесь. Меньше тройки вы не получите». Дети и не волновались…

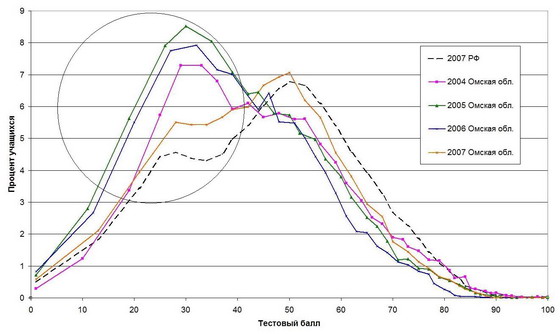

Чтобы оценить масштабы халтуры, приведём распределение учащихся по тестовому баллу в период с 2004 по 2007 год (рис.8), которое свидетельствует, что в первые три года участия Омской области в ЕГЭ на экзамене по математике просто «от фонаря» проставили крестики свыше трети выпускников - 34% (в 2007г. - 26%)! (Значения, соответствующие результативности гадания обведены кружком.) Обескуражено фиксируя низкие показатели, ни Омский аналитический центр, ни местное министерство образования об этом даже не догадывались, и по итогам ЕГЭ региональные руководители отрасли из года в год беспомощно краснели перед губернатором.

Рис. 8. Распределение омских учащихся по тестовому баллу (математика)

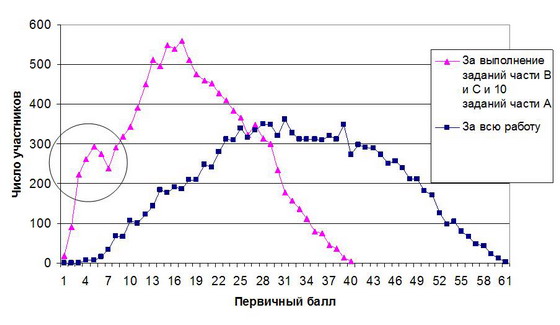

Следы бойкота ЕГЭ мы найдем и в результатах по русскому языку. Они проявляются в виде левостороннего подъема линии графика распределения по баллам, особенно хорошо заметного в 2008 году (т.е. до отмены правила «+1») (рис.2). Масштабы саботажа здесь тоже поддаются оценке. Для этого воспользуемся следующим приемом: при подсчете первичного балла уменьшим число вопросов части А до 10, как это было в математике. Таким образом мы получили, например, графики распределения омских выпускников по первичным баллам за всю работу (нормальное распределение) и по сумме баллов за части В и С и любых 10 заданий части А (бимодальное распределение). Второй из них свидетельствует, что в 2008 году около 15% омских учащихся, не мудрствуя, отмечали варианты ответов наобум (рис.9). Аналогичные результаты, правда, в несколько меньших размерах обнаружились и при исследовании результатов 2009 года. В 2010–2011 годах из-за отмены правила «+1» саботаж ЕГЭ по русскому языку в омских школах сошел на нет.

Рис. 9. Распределение омских учащихся (11 тыс. чел) по первичному баллу в 2008 году (русский язык)

Игнорировали условия проведения испытаний не только в Омске. Исследователи из Мурманска в 2008 году наблюдали резкий спад результатов по математике, объясняя его ухудшением подготовки, в 2009 году - столь же резкий подъем, вызванный ее улучшением. Чем были вызваны эти колебания, объяснить они не смогли.

Аналитики Московской области в 2008 году приводят таблицу зависимости тестового балла от количества часов в неделю изучения математики, из которой следует, что разница в успехах учащихся обучающихся 4 часа (гуманитарный класс), 5 часов (общеобразовательный класс) и 6 часов (профильный класс) невелика. Далее следует вывод:

«Это говорит как о примерном равенстве контингента учащихся разных классов, так и о том, что многие учителя при большем числе учебных часов не столько расширяют и углубляют знания учащихся, сколько решают большее число однотипных заданий. Однако отработка навыков не дает должного эффекта».

О том, что расширение состава участников, правило «+1» и обязательность экзамена стимулировали его саботаж специалисты, видимо, не подозревают. А ведь именно последний вел к нивелировке тестового балла у изучаемых групп.

В 2009 году в поисках причин общих успехов специалисты Московской области последовательно перебирают и сравнивают с прошлогодними результаты выполнения отдельных заданий. Не найдя существенных изменений в редакции КИМов, они делают выводы об улучшении уровня подготовки, верно заметив при этом, что рост показателей произошел в заданиях с выбором ответа. Задания с кратким ответом остались в минусе. Поэтому последовало следующее заключение: «Так как содержание заданий ЕГЭ–2009 не претерпело существенных изменений по сравнению с прошлым годом, трудно оценить прогресс или регресс знаний учащихся по всей школьной программе». Проигнорировав изменения условий испытаний, исследователи зашли в тупик. Отмена гарантированной тройки снизила формальное участие школьников и гадание в части А, вызвав рост ее решаемости. По части В результаты, наоборот, ухудшились, т.к. гадать там было невозможно. Поэтому вывод по Московской области должен быть другим: в 2009 году работа выполнена хуже, чем в 2008-м.

На эти же грабли наступают в Новосибирске. Здесь так объясняют повышенные результаты в 2009 году:

«В то же время существенное увеличение среднего балла по математике (на 22%) является следствием интенсификации процесса подготовки выпускников к ЕГЭ. При этом важно понимать, что в этот процесс включаются не только школьные учителя, но и подготовительные курсы вузов, репетиторы и пр. Немаловажную роль в получении такого прироста в величине среднего балла сыграли и штатный режим экзамена, и принятие педагогической общественностью его обязательности».

О том, что из-за отмены правила «+1» школьники просто перестали гадать, аналитикам в голову не пришло. Далее они по той же причине делают еще один неверный вывод, объясняя повышение коэффициента корреляции результатов ЕГЭ и школьных оценок в 2009 году возросшей адекватностью оценивания учителем предметных достижений обучающихся.

Ошибки в оценке ситуации на местах отчасти лежат на совести ФИПИ, ибо бойкот экзамена он замалчивал. Графики 2004–2009 гг., опубликованные в отчетах института, содержат несложную уловку. Они выполнены в виде гистограмм, где значения, соответствующие угадыванию ответов, спрятаны в суммах интервалов шкалы и не бросаются в глаза, а потому не комментируются. В 2009 году повышение результата по математике ФИПИ, например, объясняет усиленной подготовкой, скрывая факт формального участия школьников на ЕГЭ–2008:

«Наблюдаемая тенденция некоторого повышения уровня математической подготовки выпускников средней школы в 2009 году обусловлена в значительной степени тем, что они были мотивированы на продуктивную подготовку к выпускному экзамену в связи с отменой правила "+1” при оценке выполнения вариантов КИМ».

2. Сопоставление средних баллов по дисциплинам с общероссийскими показателями. Пожалуй, самой распространенной ошибкой являются сравнения региональных результатов с общероссийскими. Такие сопоставления с учетом ряда оговорок можно делать только по обязательным предметам. В дисциплинах по выбору необходимо обращать внимание на контингент участников, т.к. он может не отражать действительной структуры школьников всей страны. Например, состав учащихся, сдающих французский язык, наполовину представлен выпускниками Москвы, Московской области и Санкт-Петербурга, которые в значительной мере и формируют этот якобы «общероссийский» балл. Сравнение тут идет не со «среднероссийским», а со «среднестоличным» уровнем. И имеет ли смысл высчитывать региональный балл, если участников экзамена можно пересчитать по пальцам?

При сравнении баллов по обязательным предметам необходимо также учитывать особенности социального развития каждой местности, в частности их урбанизацию, поскольку в регионах с повышенной долей городского населения показатели всегда будут выше. Видимо, межрегиональные сопоставления корректны среди территорий со сходными социально-экономическими условиями функционирования образовательных учреждений: например, на уровне федеральных округов, результаты которых ФИПИ, к сожалению, не публикуется.

3. Сопоставление среднего балла по дисциплинам. Простыми и наглядными, казалось бы, выглядят сравнения средних баллов по разным дисциплинам. Сами собой напрашиваются выводы о том, по какому предмету школьники лучше учатся. Так составители одного из отчетов пишут:

«Представляется, что в целом по сравнению с результатами, продемонстрированными при сдаче других экзаменов, результаты по обществознанию выглядят достаточно неплохо, если учесть, что для данного экзамена был установлен наиболее высокий минимальный балл».

Между тем представляется некорректным сравнивать средние баллы по разным дисциплинам. На итоги экзамена самым непосредственным образом влияют содержание, количество, характер и сложность заданий, которые при межпредметных сопоставлениях невозможно соотнести. Тот факт, что средний балл по русскому языку составил 57, а по математике 44, вовсе не означает, что русский язык школьники лучше знают. Один только формат КИМов, где превалируют задания, позволяющие угадывать ответы (русский язык), дает ощутимую фору его участникам перед школьниками, вынужденными давать краткий ответ (математика). В экзаменах по выбору к тому же имеются значительные отличия в составе участников, поэтому средний балл показывает уровень только их подготовки.

«…на результаты ЕГЭ могут влиять различные факторы: состав участников, особенности КИМ, организационные особенности проведения экзамена и др. В этой связи нельзя однозначно сравнивать результаты по разным предметам, даже тестовые баллы, полученные по обязательным предметам и предметам по выбору».